Il y a d’abord eu l’invention du papier, puis… les moteurs de recherche ! We can trace the origins of data storage, transfer, and presentation to thousands of years back before the invention of paper when people wrote on bamboo slips with ink of soot, or when cavemen made marks on pieces of ochre rock 77000 years ago, but let’s start this exploration with the invention of the first “search engine” by Emanuel Goldberg in 1927 which he called une « machine statistique ». Voir le brevet américain ici.

L’une de ces machines aurait été intégrée au bureau de Goldberg, et un de ses collègues aurait déclaré : : “Il nous disait qu’il était la seule personne au monde, à sa connaissance, à avoir sur son bureau une capacité de récupération de documents… Il composait un numéro, appuyait sur un bouton et après trois secondes [a microfilmed copy of] le document serait projeté. Avance rapide jusqu’à aujourd’hui, presque tout le monde a une machine, ou deux, sur son bureau et peut-être une autre dans sa poche avec une telle capacité .

Quelle que soit la manière dont les données sont stockées, transférées et présentées, et quel que soit l’endroit où les données sont utilisées, la valeur des données est fonction de leur actualité, de leur pertinence et de leur exactitude. Lorsque les données sont actuelles, exactes et pertinentes, les informations sont fournies à l’utilisateur qui peut alors les utiliser immédiatement. C’est pourquoi nous avons fait depuis longtemps des progrès dans la recherche d’informations (le traçage et la récupération d’informations spécifiques à partir des données stockées ) et continue de le faire ; faire passer le processus de récupération d’un processus manuel fortement dépendant des humains à un processus toujours automatisé construit sur la puissance des machines .

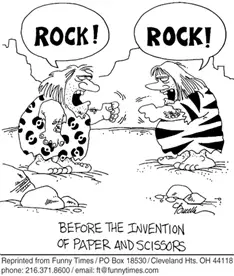

Dans les applications métier modernes, différents domaines de données (par exemple, les matériaux, les clients) sont introduits dans SAP ou des systèmes métier similaires, souvent sous forme d’entrées de données indépendantes, et sont stockés dans leurs tables et champs respectifs. Plus tard, ils sont récupérés pour être combinés en vues informatives permettant d’atteindre les objectifs commerciaux. La récupération de données à des fins professionnelles nécessite des connaissances sur les règles spécifiques au domaine. . Les règles métier et la logique définissent la signification des éléments de données .

Dans les systèmes traditionnels utilisant la logique booléenne dans les modèles de recherche (et beaucoup le font encore aujourd’hui), la plupart des connaissances commerciales étaient détenues par des experts dans des domaines spécifiques . Ainsi, l’obtention d’informations pour n’importe quel cas d’utilisation a été effectuée par l’expert correspondant (ou des équipes d’experts pour ceux qui ont de la chance)). Ce n’est pas différent de l’époque où les hommes des cavernes faisaient des marques géométriques sur des morceaux de roche, où seuls ceux qui connaissaient la signification de ces marques pouvaient récupérer des informations à partir d’une collection de roches marquées.. Dans ce modèle, du point de vue de la génération de valeur commerciale à partir des données, les entreprises mettent tous leurs œufs dans le même panier : le fait que les données soient actuelles, exactes ou pertinentes dépend d’une personne ou d’un groupe de personnes.

timely2

timely2Cela ne veut pas dire qu’il est mauvais pour les entreprises de dépendre des humains, après tout, nous resterons toujours les bienfaiteurs et les bénéficiaires des entreprises. Même si les entreprises ne seront peut-être jamais entièrement automatisées par les machines, il s’est avéré que tirer parti des atouts des machines pour compenser nos faiblesses améliore l’efficacité des entreprises.

Le développement d’algorithmes de recherche plus complexes tels que la correspondance approximative de chaînes et la pondération TF-IDF, a donné naissance à des modèles de recherche probabilistes capables de produire non seulement des correspondances exactes mais également proches d’une requête. Cependant, dans ce modèle, les résultats peuvent ne pas contenir les informations souhaitées car la signification d’une requête n’est pas comprise par le système.. Les modèles booléen et probabiliste tournent tous deux autour de la correspondance de modèles avec du texte., ce qui n’a pas énormément contribué à la pertinence des données récupérées.

timely3

timely3Aujourd’hui, les systèmes qui exploitent l’apprentissage automatique combinent l’utilisation de Algorithmes booléens et statistiques de correspondance et de classement, ainsi que techniques de traitement du langage naturel (NLP) pour améliorer l’expérience de recherche des utilisateurs. Les entreprises ayant désormais accumulé des décennies de données à analyser, la PNL offre aux entreprises un nouveau moyen d’améliorer la valeur de leurs données. Grâce au NLP et à l’apprentissage automatique, les informations les plus significatives deviennent facilement disponibles à partir des systèmes d’entreprise. dès que des requêtes proviennent du monde extérieur, le tout sans aucune intervention humaine dans la saisie, la traduction, la correction et la sortie des données, car l’analyse a été effectuée pour extraire le sens des données pour un contexte donné. C’est comme si les hommes des cavernes qui visitaient la grotte de Sibudu à plus de 1 500 km (environ la distance entre la Floride et New York) pouvaient immédiatement comprendre les marques rocheuses utilisées. par ceux de la grotte de Blombos, et pouvait donc récupérer rapidement un morceau de roche pour une utilisation immédiate.

timely4

timely4La PNL est un sujet de recherche brûlant depuis des décennies, et sa mise en œuvre peut aller de la simple identification de synonymes et de racines à l’étiquetage plus complexe de parties du discours ou à la désambiguïsation d’un texte. Pour une entreprise, par exemple, des modèles complexes d’apprentissage automatique pour la récupération d’informations peuvent combiner la PNL avec des synonymes industriels et des termes techniques dérivés (par exemple, unités de mesure) de l’analyse des données démographiques des clients, de l’historique des achats et des données saisonnières, afin que le système puisse interpréter correctement. la requête d’un client pour « pomme » en tant que demande de matériaux contenant « iPhone ». À mesure que davantage de données provenant d’une plus grande variété de sources sont utilisées pour former une analyse intégrée dans un modèle d’apprentissage automatique, la complexité de la solution augmente, tout comme la valeur des données qui résident dans les systèmes d’entreprise.

timely5

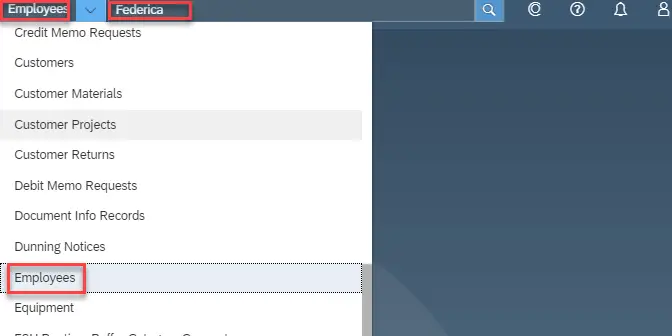

timely5Heureusement, avec une gamme aussi large d’outils analytiques disponibles aujourd’hui, l’équipe d’apprentissage automatique de DataXstream s’est employée à résoudre ces complexités en triant les données des clients, en effectuant des analyses statistiques et NLP et en créant des modèles d’apprentissage automatique qui donnent plus de sens aux données. Dans la prochaine partie de cette série d’exploration de l’apprentissage automatique et de la récupération d’informations, nous examinerons de manière technique comment la recherche a évolué de SAP R/3 à SAP S/4 HANA, et comment les entreprises peuvent tirer parti du NLP et de l’apprentissage automatique pour apporter recherche avancée au niveau suivant. En attendant, j’aimerais avoir votre avis sur l’évolution de la fonctionnalité de recherche de votre organisation au fil du temps et sur ce que vous envisagez pour son avenir.

En savoir plus sur le travail que nous effectuons au sein de l’équipe d’apprentissage automatique ici : L’apprentissage automatique et l’intelligence artificielle améliorent l’expérience OMS+ .